A história, em sua essência, é uma tapeçaria complexa de eventos, decisões e transformações que se desenrolam ao longo do tempo. Compreender essa intrincada rede de acontecimentos, especialmente no que tange à identificação de suas causas profundas e suas consequências de longo alcance, sempre foi um dos maiores desafios para historiadores e pesquisadores. A tarefa de discernir o que levou a um determinado evento e o que dele resultou é frequentemente obscurecida pela vastidão de informações, pela subjetividade das fontes e pela própria natureza multifacetada da realidade humana. Em um mundo cada vez mais impulsionado por dados e tecnologia, surge uma nova e poderosa ferramenta para auxiliar nessa empreitada: os algoritmos.

Tradicionalmente, a análise histórica tem se apoiado na interpretação cuidadosa de documentos, artefatos e narrativas, exigindo uma profunda imersão no contexto e uma capacidade aguçada de síntese por parte do historiador. No entanto, o volume de dados históricos disponíveis hoje – desde digitalizações de manuscritos antigos até vastos arquivos de jornais, registros governamentais e até mesmo dados de redes sociais – ultrapassa em muito a capacidade de qualquer indivíduo ou equipe de processar e analisar manualmente. É nesse cenário que os algoritmos, sequências lógicas de instruções projetadas para resolver problemas ou executar tarefas, emergem como aliados indispensáveis.

Este artigo se propõe a explorar como a aplicação estratégica de algoritmos pode revolucionar a forma como abordamos a pesquisa histórica, oferecendo novas perspectivas e ferramentas para desvendar as complexas relações de causa e efeito que moldaram o passado. Abordaremos desde a definição fundamental de algoritmos no contexto da análise de dados históricos até a sua aplicação prática na identificação de causas e no rastreamento de consequências, sem deixar de lado os desafios inerentes e as considerações éticas que acompanham essa abordagem inovadora. Ao final, ficará evidente que, embora os algoritmos não substituam a perspicácia e a interpretação humana, eles ampliam significativamente o horizonte da investigação histórica, permitindo-nos mergulhar mais fundo nos mistérios do tempo e extrair insights que antes seriam inatingíveis.

O Que São Algoritmos e Por Que São Relevantes para a História?

Para compreender a relevância dos algoritmos no estudo da história, é fundamental primeiro definir o que são e como operam. Em sua essência, um algoritmo é um conjunto finito de instruções bem definidas e não ambíguas, que, quando executadas em uma sequência específica, resolvem um problema ou realizam uma tarefa. Pense em uma receita de bolo: ela é um algoritmo que, se seguido corretamente, resulta em um bolo. No contexto da computação e da análise de dados, algoritmos são programas ou rotinas que processam informações, identificam padrões, fazem previsões ou classificam dados. Eles são a espinha dorsal de tudo, desde a forma como um motor de busca organiza resultados até como um sistema de recomendação sugere filmes.

A análise histórica tradicional, embora rica em profundidade e nuance, enfrenta limitações inerentes, especialmente quando confrontada com a escala e a complexidade dos dados históricos disponíveis hoje. A principal limitação reside na capacidade humana de processar e sintetizar informações. Historiadores dedicam anos à pesquisa, lendo e interpretando documentos, mas mesmo os mais diligentes não conseguem absorver a totalidade dos registros de uma época. Além disso, a interpretação humana, por mais rigorosa que seja, é inevitavelmente influenciada por vieses cognitivos, perspectivas culturais e a própria experiência do pesquisador. Isso não desvaloriza a análise tradicional, mas aponta para a necessidade de ferramentas complementares que possam mitigar essas limitações.

É aqui que os algoritmos demonstram seu valor inestimável. Eles não se cansam, não se distraem e não possuem vieses inerentes (embora possam aprender e replicar vieses presentes nos dados com os quais são treinados, um ponto que abordaremos mais adiante). Sua capacidade de processar grandes volumes de dados em velocidades que seriam impossíveis para um ser humano é o que os torna revolucionários para a pesquisa histórica. Imagine ter acesso a milhões de documentos históricos – cartas, diários, jornais, registros governamentais, censos, transcrições de julgamentos – e a capacidade de analisá-los em busca de padrões, tendências e anomalias. Os algoritmos tornam isso uma realidade.

Os dados históricos, que antes eram acessíveis apenas através de pesquisa manual em arquivos físicos, estão sendo cada vez mais digitalizados e disponibilizados em formatos que podem ser lidos e processados por máquinas. Isso inclui textos digitalizados, bases de dados de censos, registros genealógicos, mapas históricos georreferenciados, e até mesmo coleções de imagens e áudios. A capacidade de aplicar algoritmos a esses vastos conjuntos de dados abre novas avenidas para a investigação, permitindo que os historiadores explorem questões em uma escala e com uma granularidade sem precedentes.

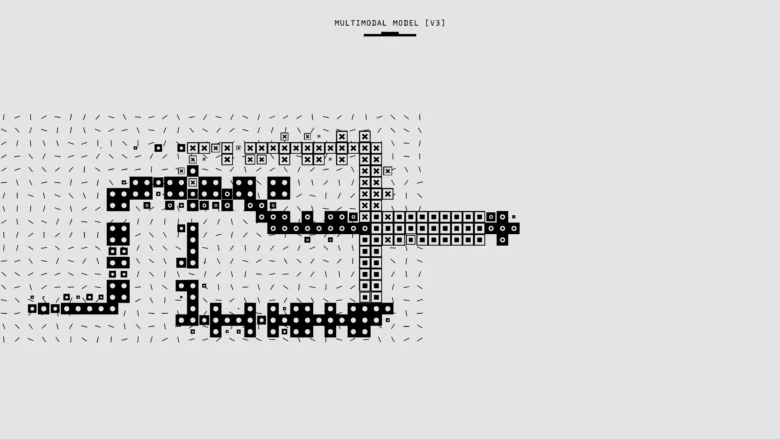

Existem diversos tipos de algoritmos que são particularmente aplicáveis ao estudo da história. A mineração de texto e o Processamento de Linguagem Natural (PLN) são cruciais para extrair informações e padrões de documentos textuais. Algoritmos de análise de redes podem mapear relações sociais, políticas e econômicas entre indivíduos, instituições ou eventos. O aprendizado de máquina, um subcampo da inteligência artificial, permite que os sistemas aprendam com os dados e identifiquem padrões complexos, o que pode ser usado para classificar documentos, prever tendências ou até mesmo reconstruir informações ausentes. Além disso, algoritmos estatísticos tradicionais, como os de correlação e regressão, podem ser empregados para analisar relações entre variáveis quantificáveis, como dados demográficos, econômicos ou climáticos. A combinação dessas abordagens algorítmicas oferece um arsenal poderoso para desvendar as complexidades do passado.

Identificando Causas Históricas com Algoritmos

A busca pelas causas de eventos históricos é uma das tarefas mais fundamentais e desafiadoras da historiografia. Muitas vezes, um evento é o resultado de uma confluência de fatores, alguns óbvios, outros sutis e interconectados. Os algoritmos, com sua capacidade de processar e analisar grandes volumes de dados de forma sistemática, oferecem novas abordagens para desvendar essas complexas teias causais. Eles permitem que os historiadores identifiquem padrões, correlações e anomalias que seriam difíceis, senão impossíveis, de perceber através da análise manual.

Análise de Correlação e Regressão

Uma das aplicações mais diretas dos algoritmos na identificação de causas históricas reside na análise de correlação e regressão. Essas técnicas estatísticas permitem quantificar a relação entre duas ou mais variáveis. Por exemplo, um historiador pode estar interessado em saber se houve uma correlação entre períodos de seca prolongada e o aumento de revoltas camponesas em uma determinada região e época. Ao coletar dados sobre precipitação, produção agrícola e ocorrência de revoltas ao longo de décadas ou séculos, algoritmos de correlação podem calcular a força e a direção dessa relação. Se uma correlação positiva forte for encontrada, isso sugere que, à medida que a seca se intensificava, as revoltas tendiam a aumentar.

Da mesma forma, a análise de regressão vai um passo além, permitindo modelar como uma variável (a variável dependente, como o número de revoltas) pode ser explicada ou prevista por uma ou mais variáveis (as variáveis independentes, como a precipitação ou o preço dos alimentos). Isso pode ajudar a identificar quais fatores têm o maior impacto e em que medida. Por exemplo, um modelo de regressão poderia indicar que uma queda de 20% na produção de grãos estava associada a um aumento de 15% na probabilidade de uma revolta. Essas análises podem ser aplicadas a uma vasta gama de dados quantificáveis, como dados demográficos (taxas de natalidade, mortalidade, migração), econômicos (preços de commodities, salários, taxas de juros), climáticos (temperatura, precipitação) e sociais (taxas de criminalidade, alfabetização).

No entanto, é crucial sublinhar uma advertência fundamental: correlação não implica causalidade. O fato de duas variáveis se moverem juntas não significa necessariamente que uma causa a outra. Pode haver uma terceira variável, não observada, que está influenciando ambas, ou a relação pode ser puramente coincidente. Por exemplo, o aumento no consumo de sorvete e o aumento de afogamentos podem correlacionar-se fortemente, mas ambos são causados por um terceiro fator: o calor do verão. Portanto, os resultados de análises de correlação e regressão devem ser interpretados com cautela e sempre contextualizados com o conhecimento histórico profundo. Eles servem como indicadores de possíveis relações causais que exigem investigação qualitativa e aprofundada para serem confirmadas ou refutadas.

Mineração de Texto e Processamento de Linguagem Natural (PLN)

Para a vasta maioria das fontes históricas, que são textuais, a mineração de texto e o Processamento de Linguagem Natural (PLN) são ferramentas algorítmicas de valor inestimável. Essas técnicas permitem que computadores “leiam” e “compreendam” o conteúdo de documentos de uma forma que vai muito além da simples busca por palavras-chave. Com o PLN, é possível extrair informações estruturadas de textos não estruturados, identificar entidades (pessoas, lugares, organizações), reconhecer relações entre elas, analisar o sentimento expresso e até mesmo detectar tópicos e temas que emergem de grandes coleções de documentos.

Imagine um historiador estudando as causas da Revolução Francesa. Em vez de ler manualmente milhares de panfletos, jornais e correspondências da época, ele pode usar algoritmos de PLN para:

- Extrair termos e conceitos-chave: Identificar a frequência e a co-ocorrência de palavras como “liberdade”, “igualdade”, “fraternidade”, “fome”, “impostos”, “rei”, “nobreza” e como seu uso evoluiu ao longo do tempo. Um aumento súbito na menção de “fome” e “impostos” em panfletos populares, por exemplo, poderia indicar uma crescente insatisfação econômica como causa.

- Análise de Sentimento: Avaliar o tom emocional dos textos. Algoritmos podem classificar frases ou documentos como positivos, negativos ou neutros em relação a determinados temas ou figuras. Uma crescente negatividade em relação à monarquia ou à aristocracia em documentos públicos poderia sinalizar uma erosão da legitimidade e um aumento do descontentamento popular.

- Modelagem de Tópicos (Topic Modeling): Identificar os principais temas discutidos em uma coleção de documentos sem a necessidade de pré-definir esses temas. Algoritmos como o Latent Dirichlet Allocation (LDA) podem descobrir grupos de palavras que frequentemente aparecem juntas, formando “tópicos” abstratos. A emergência de novos tópicos ou a intensificação de discussões sobre tópicos específicos (como direitos civis, dívida pública ou corrupção) em um período anterior a um evento pode apontar para as causas subjacentes.

- Reconhecimento de Entidades Nomeadas (NER): Identificar e classificar nomes de pessoas, lugares, organizações e datas. Isso é crucial para construir redes de interações e para contextualizar eventos. Por exemplo, a frequência com que certos líderes ou grupos são mencionados em conjunto com determinadas ideias ou eventos pode revelar sua influência causal.

Os desafios do PLN em fontes históricas incluem a variação linguística ao longo do tempo (ortografia antiga, mudanças de significado), a qualidade da digitalização (erros de OCR) e a necessidade de modelos de linguagem treinados em dados históricos específicos. No entanto, com o avanço das técnicas e a disponibilidade de corpora históricos, o PLN está se tornando uma ferramenta indispensável para desvendar as narrativas e os discursos que moldaram o passado, revelando as ideias e as tensões que atuaram como causas.

Análise de Redes

A análise de redes é outra abordagem algorítmica poderosa para identificar causas históricas, especialmente aquelas relacionadas a interações sociais, políticas e econômicas. A história é, em grande parte, a história de pessoas e grupos interagindo, formando alianças, exercendo influência e disseminando ideias. A análise de redes permite mapear essas conexões e identificar estruturas subjacentes que podem ter um impacto causal significativo.

Uma rede é composta por “nós” (que podem ser indivíduos, organizações, cidades, países, eventos, ideias) e “arestas” (as conexões ou relações entre esses nós). Por exemplo, em uma rede social histórica, os nós poderiam ser figuras políticas e as arestas, suas correspondências, reuniões ou afiliações a partidos. Em uma rede econômica, os nós poderiam ser cidades e as arestas, rotas comerciais ou fluxos de bens.

Algoritmos de análise de redes podem ser usados para:

- Identificar Atores Centrais (Centralidade): Medir a importância ou influência de um nó dentro da rede. Diferentes métricas de centralidade (grau, intermediação, proximidade, autovetor) podem revelar quem eram os indivíduos ou grupos mais conectados, os que atuavam como pontes entre diferentes comunidades, ou os que tinham acesso mais rápido à informação. Esses atores centrais frequentemente desempenham um papel causal desproporcional nos eventos históricos.

- Detectar Comunidades ou Cliques: Identificar grupos de nós que estão mais densamente conectados entre si do que com o resto da rede. A formação ou dissolução de comunidades (como facções políticas, grupos de intelectuais ou redes de comércio) pode ser uma causa fundamental para mudanças sociais ou políticas. Por exemplo, a emergência de um grupo coeso de revolucionários pode ser um fator causal para uma revolução.

- Analisar Fluxos e Difusão: Modelar como informações, ideias, doenças ou inovações se espalham através da rede. Isso pode ajudar a entender como certas ideologias ou tecnologias se tornaram dominantes, atuando como causas para transformações sociais e culturais. Por exemplo, a análise da difusão de ideias iluministas através de redes de correspondência pode revelar como essas ideias se tornaram catalisadores para movimentos revolucionários.

- Identificar Pontos de Vulnerabilidade: Descobrir nós ou arestas cuja remoção (por exemplo, a morte de um líder, o colapso de uma rota comercial) teria o maior impacto na estrutura da rede. Esses pontos de vulnerabilidade podem ser cruciais para entender por que certos eventos tiveram consequências tão drásticas.

A construção de redes históricas exige dados detalhados sobre as relações, o que pode ser um desafio. No entanto, com a digitalização de registros como correspondências, registros de associações, diários e até mesmo genealogias, a análise de redes está se tornando uma ferramenta cada vez mais viável. Ela oferece uma lente poderosa para visualizar e quantificar as interações humanas que são frequentemente as raízes das mudanças históricas, permitindo que os historiadores identifiquem os agentes e as estruturas que atuaram como causas.

Rastreando Consequências Históricas com Algoritmos

Assim como a identificação de causas, o rastreamento das consequências de eventos históricos é uma tarefa complexa e multifacetada. As consequências raramente são lineares ou imediatas; elas podem se manifestar de diversas formas, em diferentes escalas de tempo e em múltiplos domínios – social, econômico, político, cultural. Os algoritmos oferecem métodos sistemáticos para observar e analisar as mudanças que se seguem a um evento, ajudando a discernir seus impactos de longo prazo e as ramificações inesperadas.

Modelagem Preditiva e Simulações

Embora a história seja o estudo do passado, a modelagem preditiva e as simulações com algoritmos podem ser ferramentas valiosas para entender as consequências históricas. Não se trata de prever o futuro, mas sim de explorar cenários contrafactuais ou de modelar a dinâmica de sistemas históricos para entender como certas condições ou eventos poderiam ter levado a diferentes resultados. Ao criar modelos baseados em dados históricos e aplicar algoritmos, os historiadores podem simular o que teria acontecido se um determinado evento não tivesse ocorrido, ou se tivesse ocorrido de forma diferente, ajudando a isolar o impacto de um evento específico.

Por exemplo, um historiador poderia construir um modelo algorítmico da economia de um império antes de uma grande guerra. Ao simular a economia com e sem a guerra, e com diferentes resultados da guerra, ele poderia estimar o impacto econômico direto e indireto do conflito – como a perda de produção, o aumento da dívida, a mudança nas rotas comerciais – e, assim, quantificar algumas das consequências. Da mesma forma, simulações baseadas em agentes podem modelar o comportamento de indivíduos ou grupos em resposta a um evento, como uma epidemia ou uma nova lei, e observar como essas interações em nível micro levam a consequências em nível macro.

Essas simulações podem ajudar a responder a perguntas do tipo “e se”, que são cruciais para a análise causal. Se a Revolução Industrial não tivesse ocorrido, como seria o desenvolvimento tecnológico e social? Se uma determinada batalha tivesse tido um resultado diferente, como isso teria alterado o curso de uma guerra? Os algoritmos permitem que os historiadores explorem essas hipóteses de forma mais rigorosa e baseada em dados, em vez de depender apenas da intuição. No entanto, é fundamental reconhecer as limitações: esses modelos são simplificações da realidade e suas previsões são probabilísticas, não determinísticas. Eles dependem da qualidade e completude dos dados de entrada e das suposições feitas sobre as relações entre as variáveis. A natureza probabilística dessas previsões significa que elas indicam tendências e possibilidades, não certezas absolutas.

Análise de Séries Temporais

A análise de séries temporais é uma técnica algorítmica fundamental para rastrear consequências, pois permite estudar a evolução de fenômenos ao longo do tempo após um evento. Uma série temporal é uma sequência de pontos de dados medidos em intervalos de tempo sucessivos (por exemplo, a taxa de inflação mensal, o número de nascimentos anuais, a frequência de greves por década). Ao analisar essas séries, os algoritmos podem identificar tendências, sazonalidades, ciclos e, crucialmente, pontos de mudança ou descontinuidade que podem ser atribuídos a eventos específicos.

Por exemplo, se um historiador está investigando as consequências da abolição da escravidão em um país, ele pode analisar séries temporais de indicadores econômicos (produção agrícola, salários, migração interna), sociais (taxas de alfabetização, criminalidade) e demográficos (taxas de natalidade e mortalidade) antes e depois da abolição. Algoritmos de séries temporais podem identificar se houve uma mudança estatisticamente significativa na tendência desses indicadores após o evento, sugerindo uma relação causal. Técnicas como a análise de intervenção podem ser usadas para modelar o impacto de um evento específico em uma série temporal, isolando seu efeito de outras tendências ou flutuações.

Além disso, a análise de séries temporais pode revelar a duração e a intensidade das consequências. Um evento pode ter um impacto imediato e agudo, seguido por um retorno gradual à normalidade, ou pode desencadear uma nova tendência de longo prazo. Por exemplo, a introdução de uma nova tecnologia pode não ter um impacto imediato na produtividade, mas pode levar a um crescimento exponencial ao longo de décadas. Os algoritmos ajudam a quantificar e visualizar essas dinâmicas temporais, tornando as consequências mais tangíveis e mensuráveis.

Detecção de Anomalias

A detecção de anomalias é uma aplicação algorítmica que pode ser particularmente útil para identificar consequências inesperadas ou sutis de eventos históricos. Uma anomalia é um ponto de dados ou um padrão que se desvia significativamente do comportamento esperado ou da norma. Em um contexto histórico, um evento pode ter consequências que não são imediatamente óbvias ou que se manifestam de maneiras incomuns.

Por exemplo, após uma grande reforma política, um historiador pode usar algoritmos de detecção de anomalias para examinar grandes volumes de dados (como registros de tribunais, petições populares, ou até mesmo a frequência de certas palavras em jornais) em busca de padrões incomuns. Um aumento inesperado em um tipo específico de crime, uma mudança abrupta na demografia de uma cidade, ou o surgimento de um novo vocabulário político em um determinado período podem ser anomalias que sinalizam consequências diretas ou indiretas da reforma. Esses desvios do padrão esperado podem ser difíceis de detectar manualmente em grandes conjuntos de dados, mas os algoritmos são projetados para identificar esses “outliers”.

Algoritmos de detecção de anomalias podem operar de várias maneiras, desde métodos estatísticos simples que identificam pontos fora de um determinado desvio padrão, até técnicas mais avançadas de aprendizado de máquina que aprendem o “comportamento normal” dos dados e sinalizam qualquer desvio significativo. Ao aplicar essas técnicas a dados históricos, os historiadores podem descobrir consequências que de outra forma passariam despercebidas, abrindo novas linhas de investigação e aprofundando a compreensão dos impactos de eventos passados. A capacidade de identificar esses desvios inesperados é crucial para uma compreensão completa das complexas e muitas vezes não-lineares ramificações dos eventos históricos.

Desafios e Considerações Éticas

Embora o potencial dos algoritmos para a pesquisa histórica seja imenso, é crucial abordar essa nova fronteira com uma compreensão clara dos desafios e das considerações éticas que a acompanham. A aplicação de métodos computacionais à história não é uma panaceia que resolve todos os problemas, mas sim uma ferramenta poderosa que, como qualquer ferramenta, deve ser usada com discernimento e responsabilidade.

Qualidade e Disponibilidade dos Dados

O primeiro e talvez mais fundamental desafio reside na qualidade e disponibilidade dos dados históricos. Algoritmos são tão bons quanto os dados com os quais são alimentados. A história, por sua natureza, lida com dados que são frequentemente incompletos, fragmentados, inconsistentes, e muitas vezes não foram criados com a intenção de serem analisados quantitativamente. A digitalização de arquivos históricos é um processo contínuo, mas ainda há uma vasta quantidade de material que permanece em formato analógico, inacessível aos algoritmos.

Mesmo os dados digitalizados apresentam desafios. Documentos antigos, por exemplo, podem ter sido digitalizados com erros de Reconhecimento Óptico de Caracteres (OCR), resultando em textos com palavras mal interpretadas que podem distorcer a análise de PLN. A padronização de dados é outro obstáculo significativo. Diferentes instituições podem usar diferentes formatos, vocabulários e categorizações para registrar informações, tornando a integração de conjuntos de dados diversos uma tarefa árdua. A ausência de metadados ricos e consistentes também dificulta a contextualização e a interpretação dos dados pelos algoritmos.

Além disso, a disponibilidade de dados pode ser desigual. Certas regiões, períodos ou grupos sociais podem ter sido mais bem documentados do que outros, criando lacunas significativas que podem levar a uma representação distorcida do passado. A super-representação de fontes oficiais ou de elite, em detrimento de vozes marginalizadas, é um problema persistente na historiografia que pode ser amplificado se os algoritmos forem treinados apenas nesses dados dominantes. A curadoria, limpeza e enriquecimento de dados históricos para torná-los “algoritmo-prontos” é uma tarefa monumental que exige a colaboração entre historiadores, arquivistas e cientistas de dados.

Viés Algorítmico

Um dos desafios éticos mais prementes é o viés algorítmico. Embora os algoritmos em si sejam lógicos e imparciais, eles aprendem com os dados que lhes são fornecidos. Se esses dados refletem vieses históricos, sociais ou culturais – como preconceitos de gênero, raça, classe ou nacionalidade – o algoritmo pode não apenas replicar, mas até mesmo amplificar esses vieses em suas análises e conclusões. Isso é particularmente preocupante em campos como o PLN, onde os modelos são treinados em vastos corpora de texto que podem conter linguagem carregada de preconceitos.

Por exemplo, se um algoritmo de PLN é treinado em documentos históricos que consistentemente associam certas profissões a um gênero específico, ele pode, ao analisar novos textos, inferir erroneamente que apenas homens exerciam certas funções, mesmo que a realidade fosse mais complexa. Da mesma forma, se os dados históricos disponíveis sobre um determinado grupo minoritário são predominantemente negativos ou limitados, um algoritmo pode desenvolver uma representação distorcida ou incompleta desse grupo. Isso pode levar a interpretações históricas que perpetuam estereótipos ou negligenciam a agência de grupos sub-representados.

Mitigar o viés algorítmico exige uma abordagem multifacetada. Isso inclui a curadoria cuidadosa dos dados de treinamento para identificar e, se possível, corrigir vieses; o desenvolvimento de algoritmos que sejam mais robustos a dados enviesados; e, crucialmente, a avaliação contínua dos resultados dos algoritmos por historiadores com sensibilidade crítica para identificar e questionar quaisquer conclusões que pareçam refletir preconceitos históricos. A transparência sobre as fontes de dados e os métodos algorítmicos utilizados é essencial para permitir o escrutínio e a validação por parte da comunidade acadêmica.

Interpretabilidade

Outro desafio significativo, especialmente com algoritmos de aprendizado de máquina mais complexos (como redes neurais profundas), é a interpretabilidade, ou a falta dela. Muitos desses modelos são frequentemente referidos como “caixas pretas” porque, embora possam produzir resultados altamente precisos, é extremamente difícil entender como eles chegaram a essas conclusões. Para um historiador, que busca não apenas o “o quê”, mas o “porquê” e o “como”, a incapacidade de rastrear o raciocínio de um algoritmo pode ser um obstáculo.

Se um algoritmo identifica uma correlação surpreendente ou um padrão inesperado, o historiador precisa ser capaz de investigar as razões por trás dessa descoberta. Sem a interpretabilidade, a confiança nos resultados pode ser comprometida, e a capacidade de construir narrativas históricas coerentes e bem fundamentadas é limitada. Isso não significa que algoritmos de caixa preta não tenham valor, mas que seu uso deve ser complementado por métodos que permitam a validação e a compreensão dos mecanismos subjacentes.

Pesquisas em “IA explicável” (XAI) estão tentando abordar esse problema, desenvolvendo técnicas para tornar os modelos de aprendizado de máquina mais transparentes e compreensíveis. No entanto, por enquanto, os historiadores que utilizam algoritmos devem priorizar a interpretabilidade sempre que possível, optando por modelos mais simples e transparentes quando apropriado, e sempre submetendo os resultados de modelos complexos a um rigoroso escrutínio e validação cruzada com outras fontes e métodos.

A Importância da Interpretação Humana

Talvez a consideração ética e metodológica mais importante seja a reafirmação da importância da interpretação humana. Os algoritmos são ferramentas; eles não são historiadores. Eles podem processar dados, identificar padrões e gerar insights, mas não podem formular perguntas históricas significativas, contextualizar eventos dentro de uma complexa tapeçaria cultural e social, ou construir narrativas persuasivas e empáticas. A história não é apenas uma coleção de fatos e números; é também sobre significado, experiência humana e a construção de sentido.

Os algoritmos não possuem intuição, criatividade, empatia ou a capacidade de fazer julgamentos morais e éticos – qualidades que são intrínsecas à prática histórica. Eles não podem ler nas entrelinhas de um documento com a mesma sensibilidade que um historiador experiente, nem podem compreender as nuances da agência humana ou as complexidades das motivações individuais e coletivas. A análise algorítmica deve ser vista como um complemento, e não um substituto, para a expertise do historiador.

O papel do historiador na era dos algoritmos se transforma, mas não diminui. Ele se torna o arquiteto das perguntas que os algoritmos tentarão responder, o curador dos dados que os alimentarão, o intérprete crítico dos resultados que eles produzirão e o narrador que tecerá esses insights em uma compreensão mais rica e matizada do passado. A colaboração entre historiadores e cientistas de dados é, portanto, essencial. É essa sinergia que permitirá que o campo da história avance, utilizando o poder computacional para desvendar novas camadas de complexidade, ao mesmo tempo em que mantém a profundidade, a nuance e a sensibilidade humana que são sua marca registrada.

Conclusão

A jornada através da aplicação de algoritmos para desvendar as causas e consequências históricas revela um horizonte promissor para a disciplina da história. Longe de ser uma mera curiosidade tecnológica, a integração de métodos computacionais e algorítmicos representa uma evolução significativa nas ferramentas e abordagens disponíveis para os historiadores. Vimos como os algoritmos, em suas diversas formas – desde a análise estatística de correlação e regressão até as sofisticadas técnicas de mineração de texto, Processamento de Linguagem Natural e análise de redes – podem processar volumes de dados sem precedentes, identificar padrões ocultos e revelar conexões que seriam imperceptíveis à análise manual.

Recapitulando, os algoritmos oferecem um novo conjunto de lentes para examinar o passado. Eles nos permitem quantificar relações entre variáveis históricas, extrair insights de vastas coleções de documentos textuais, mapear as complexas redes de interação humana e rastrear as ramificações de eventos ao longo do tempo. A capacidade de modelar cenários contrafactuais e de identificar anomalias em séries temporais abre novas vias para compreender a dinâmica das mudanças históricas e os impactos de longo prazo de decisões e acontecimentos.

No entanto, é imperativo reiterar que essa revolução metodológica não é isenta de desafios. A qualidade e a disponibilidade dos dados históricos, a presença de vieses inerentes nos conjuntos de dados e a complexidade da interpretabilidade de alguns modelos algorítmicos são obstáculos que exigem atenção contínua e pesquisa dedicada. A superação desses desafios passa necessariamente por uma colaboração interdisciplinar robusta, onde historiadores, com seu profundo conhecimento contextual e sua sensibilidade crítica, trabalham lado a lado com cientistas de dados, que dominam as ferramentas e técnicas computacionais.

O futuro da pesquisa histórica, portanto, não reside na substituição do historiador pela máquina, mas sim na amplificação de suas capacidades. Os algoritmos não vêm para ditar a verdade histórica, mas para oferecer novas evidências, levantar novas perguntas e desafiar suposições existentes. Eles são catalisadores para uma compreensão mais rica, mais granular e mais abrangente do passado. A ciência de dados, com sua ênfase na análise de grandes volumes de informação e na identificação de padrões, está se tornando uma aliada indispensável para a historiografia, permitindo que a disciplina explore questões em escalas e complexidades antes inimagináveis.

Em última análise, a colaboração entre historiadores e cientistas de dados é a chave para desvendar os mistérios do passado. Ao combinar a rigorosa análise contextual e interpretativa do historiador com o poder computacional e a capacidade de identificação de padrões dos algoritmos, podemos construir uma compreensão mais completa e matizada das causas e consequências que moldaram o mundo em que vivemos. É uma união que promete não apenas revelar novas facetas da história, mas também fortalecer a relevância da disciplina em um mundo cada vez mais orientado por dados. O passado, com todas as suas complexidades e lições, aguarda ser redescoberto através dessa nova e poderosa lente algorítmica.